Nlp 对比学习

一文看懂自然语言处理nlp 4个应用 5个难点 6个实现步骤

无监督学习之对比学习 Freebuf网络安全行业门户

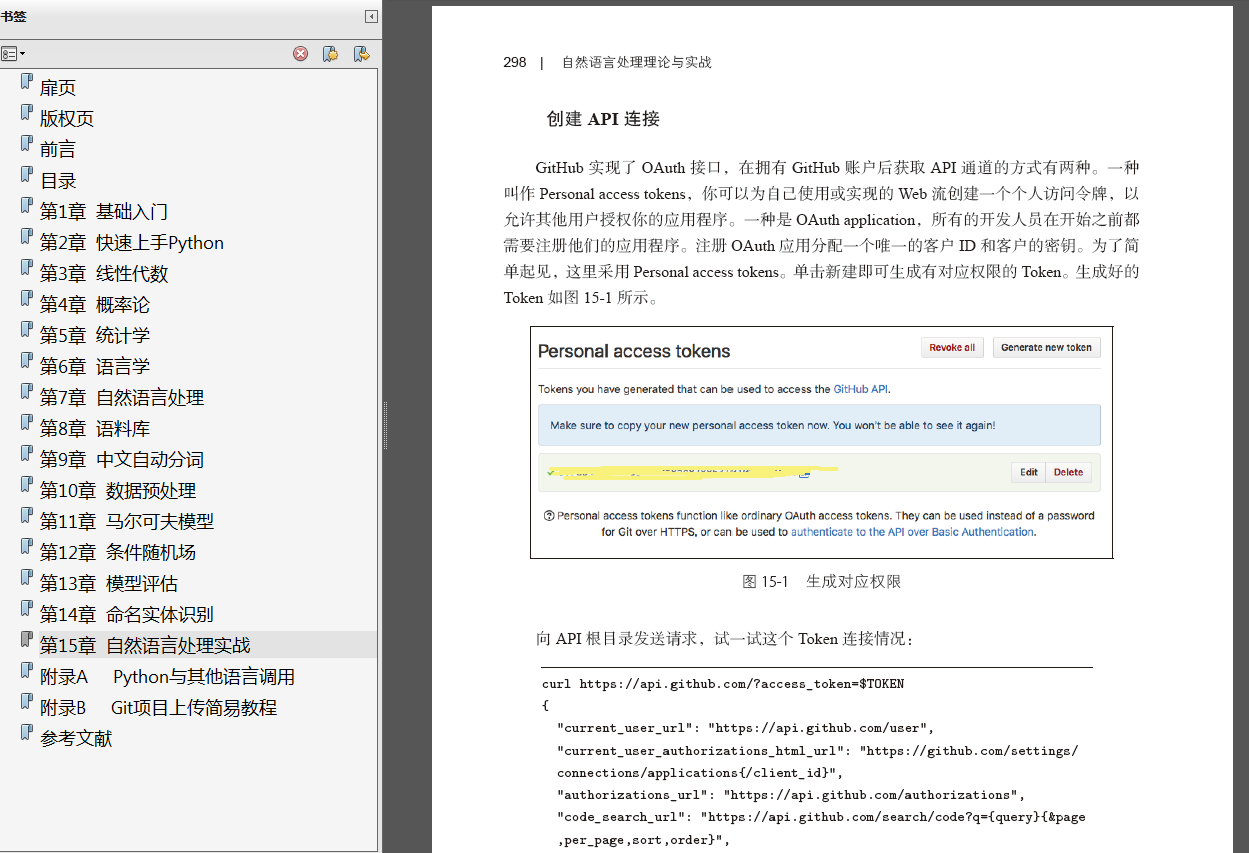

自然语言处理理论与实战 唐聃 Pdf源代码 大数据智能互联网时代的机器学习和自然语言处理技术 刘知远 Pdf 对比学习 热备资讯

年无监督对比学习 Cl 最新必读经典论文整理分享 深度学习与nlp 商业新知

机器学习13 无监督学习之自监督 航行学园

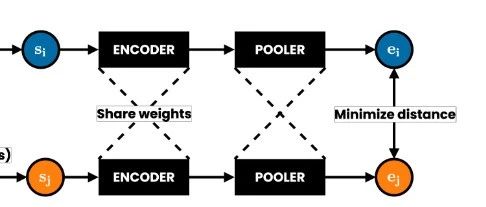

论文浅尝 Declutr 无监督文本表示的深度对比学习 专知

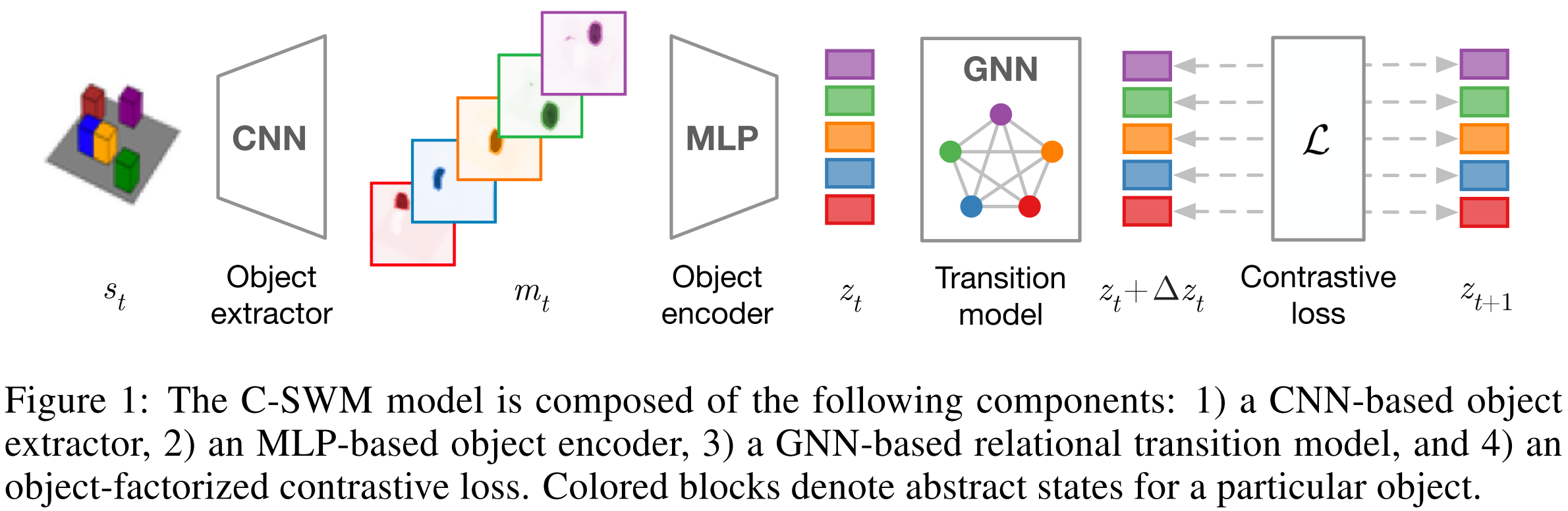

对比学习是一种可选择的补充范式,可以帮助缓解其中的一些问题。 对比学习与 masked 语言建模相结合能够让我们学习更丰富、更鲁棒的表征。它可以帮助解决模型异常值以及罕见的句法和语义现象带来的问题,这对当前的 NLP 模型是一个挑战。.

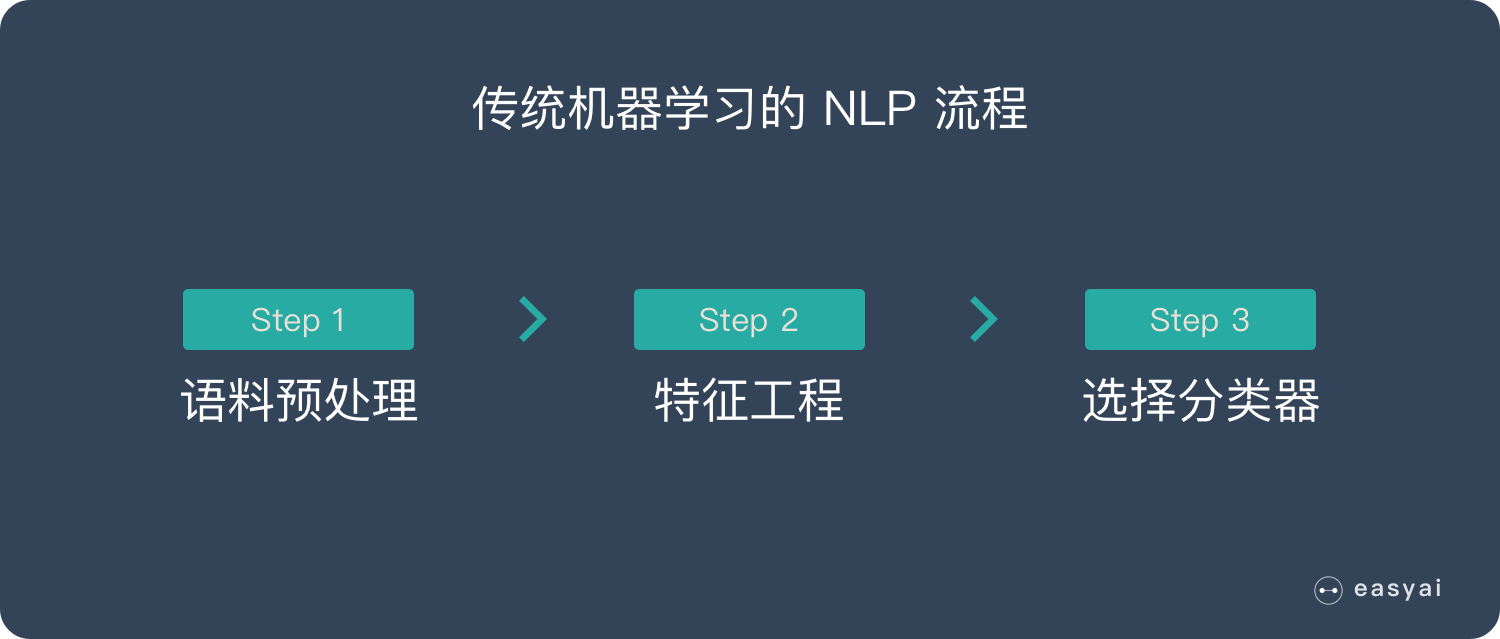

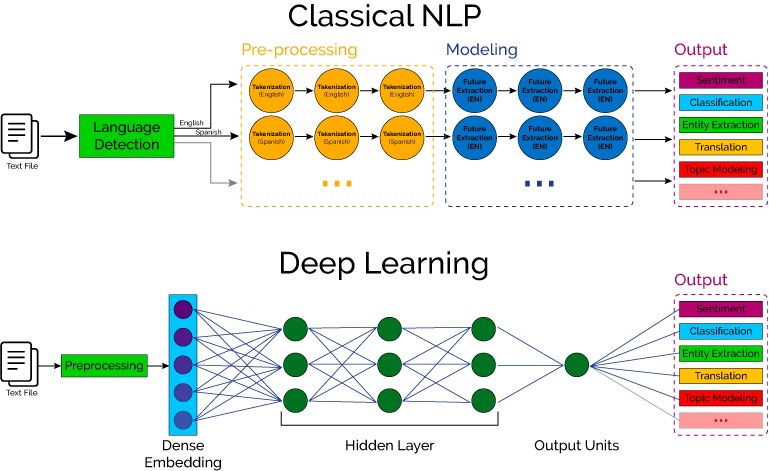

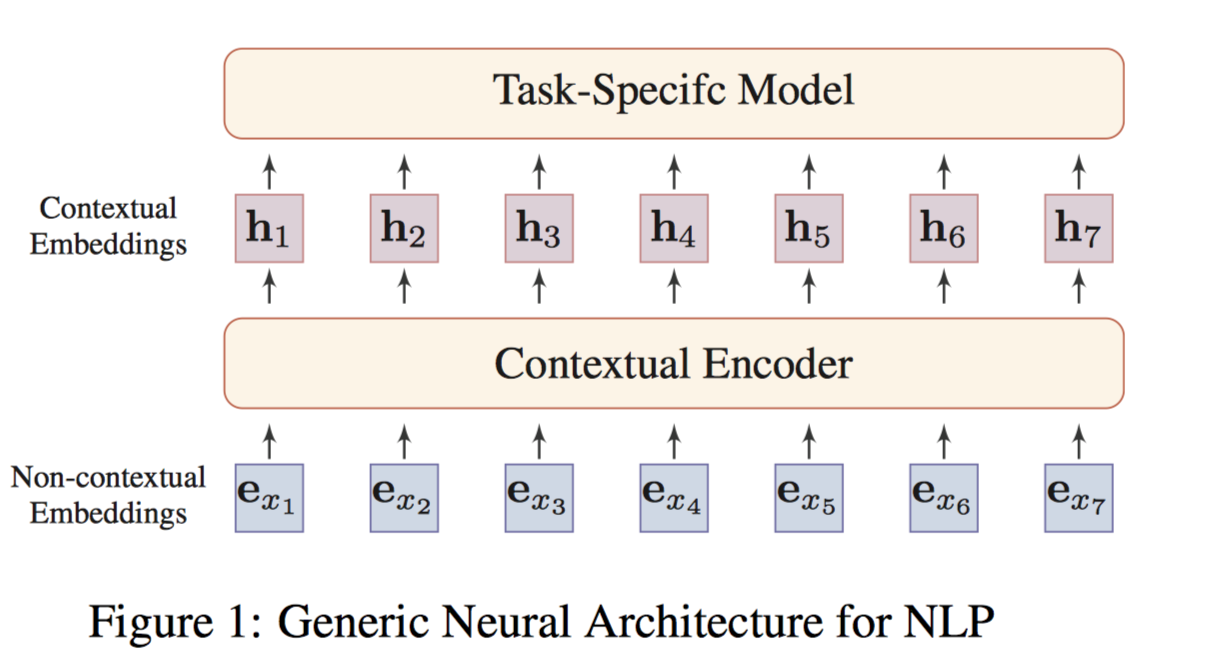

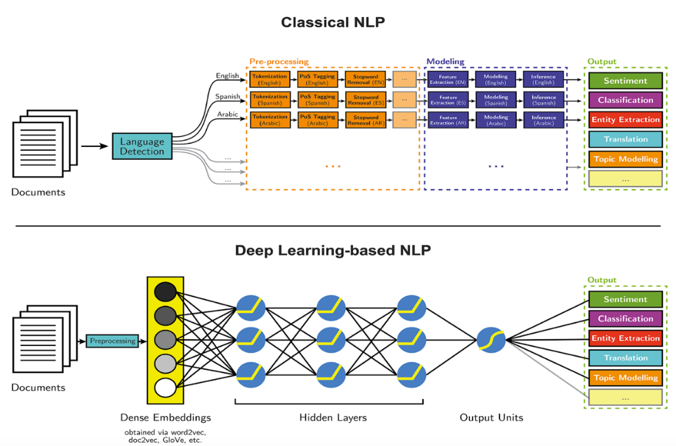

Nlp 对比学习. 与此对比的是,基于传统机器学习的nlp系统往往依赖于手工提取特征,不仅费时费力,而且往往不全。 Collobert et al 5 用一个简单的深度学习框架就在诸如命名实体识别、语义角色标注和词性标注等NLP任务上打败了最先进的方法。. ©PaperWeekly 原创 · 作者|李磊 学校|西安电子科技大学本科生 研究方向|自然语言处理 最近深度学习两巨头 Bengio 和 LeCun 在 ICLR 上点名 SelfSupervised Learning(SSL,自监督学习) 是 AI 的未来,而其的代表的 Framework 便是 Contrastive Learning(CL,对比学习)。. NLP is the study of excellent communication–both with yourself, and with others It was developed by modeling excellent communicators and therapists who got results with their clients NLP is a set of tools and techniques, but it is so much more than that It is an attitude and a methodology of knowing how to achieve your goals and get results.

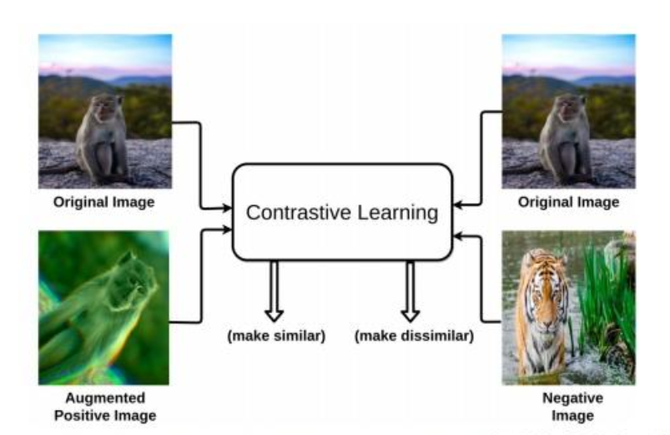

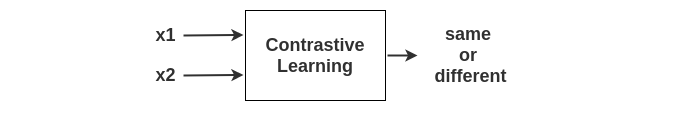

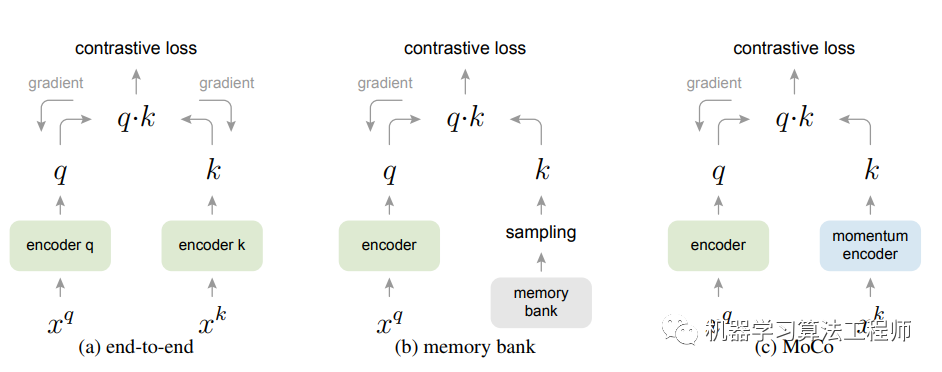

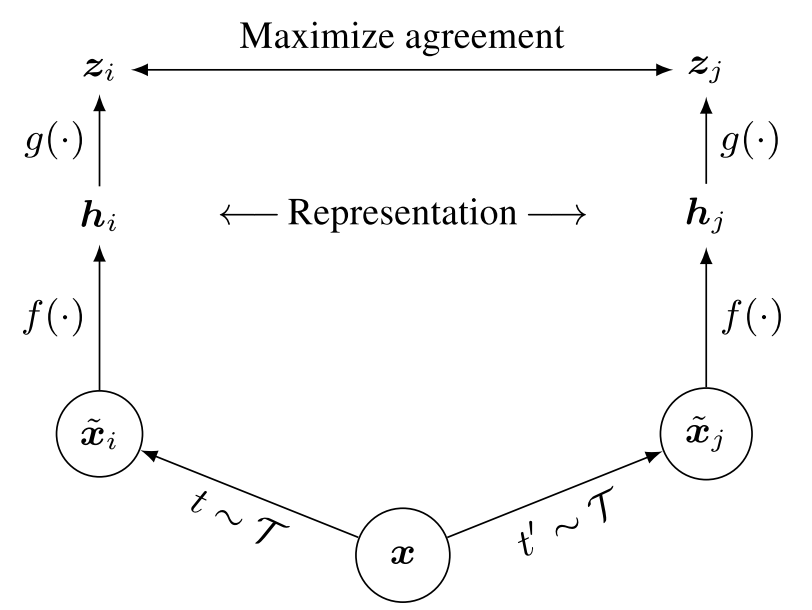

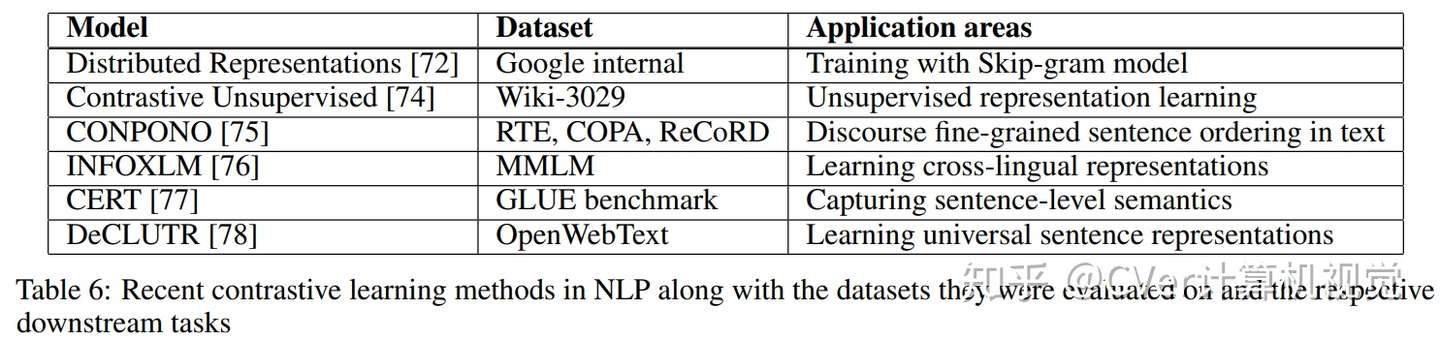

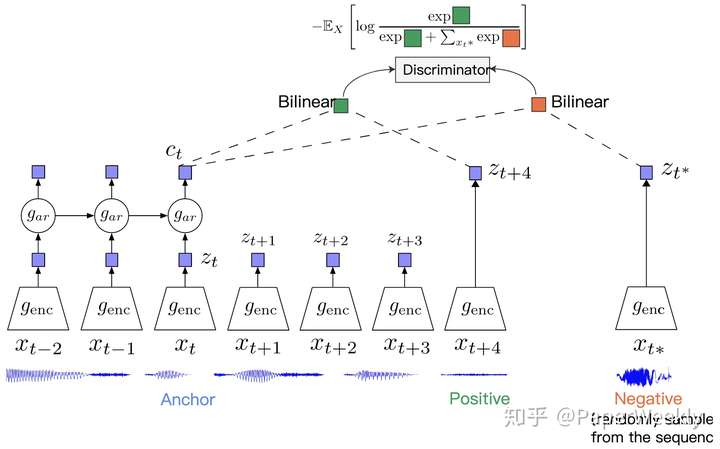

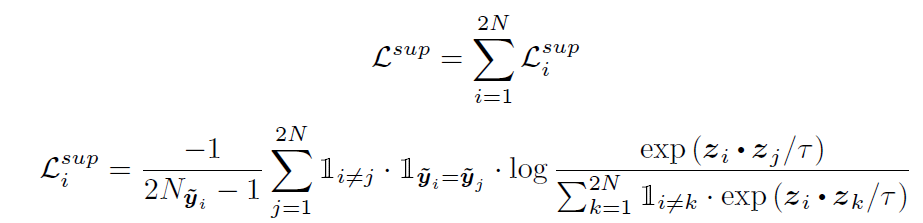

而对比方法通过正面和负面的例子来学习表征。尽管不是全新的思路,但其在计算机视觉任务中取得了较快的发展。通常自监督的对比方法也称为自监督对比学习。 Contrastive Learning 31 Contrastive Loss(InfoNCE) 对比学习的核心思想是最大化相似性和最小化差异性的. 与此对比的是,基于传统机器学习的nlp系统往往依赖于手工提取特征,不仅费时费力,而且往往不全。 Collobert et al 5 用一个简单的深度学习框架就在诸如命名实体识别、语义角色标注和词性标注等NLP任务上打败了最先进的方法。. 此时尚未有nlp,但由于熵也是nlp的基石之一,在此也算作是nlp的发展历程。 按照维基百科的说法,nlp发源于1950年。图灵于该年提出“图灵测试”,用以检验计算机是否真正拥有智能。 nlp规则时代 年,模拟人类学习语言的习惯,以语法规则为主流。.

985 研二渣硕一枚,已有机器学习基础,数学基础还凑合,但感觉纯的机器学习不太好找工作,想往图像、语音、或者 nlp 方向发展。请问哪个方向比较好转呢 显示全部. 无监督学习︱gan 在 nlp 中遇到瓶颈稀疏编码自学习对偶学习 1711 阅读 337 0 深度学习训练一个模型需要很多的人工标注的数据。. 表 1:nlp 的五个主要任务 表 2:不同方法在 nlp 问题上的表现对比 表 2 表明在示例问题上深度学习的表现已超越传统方法。.

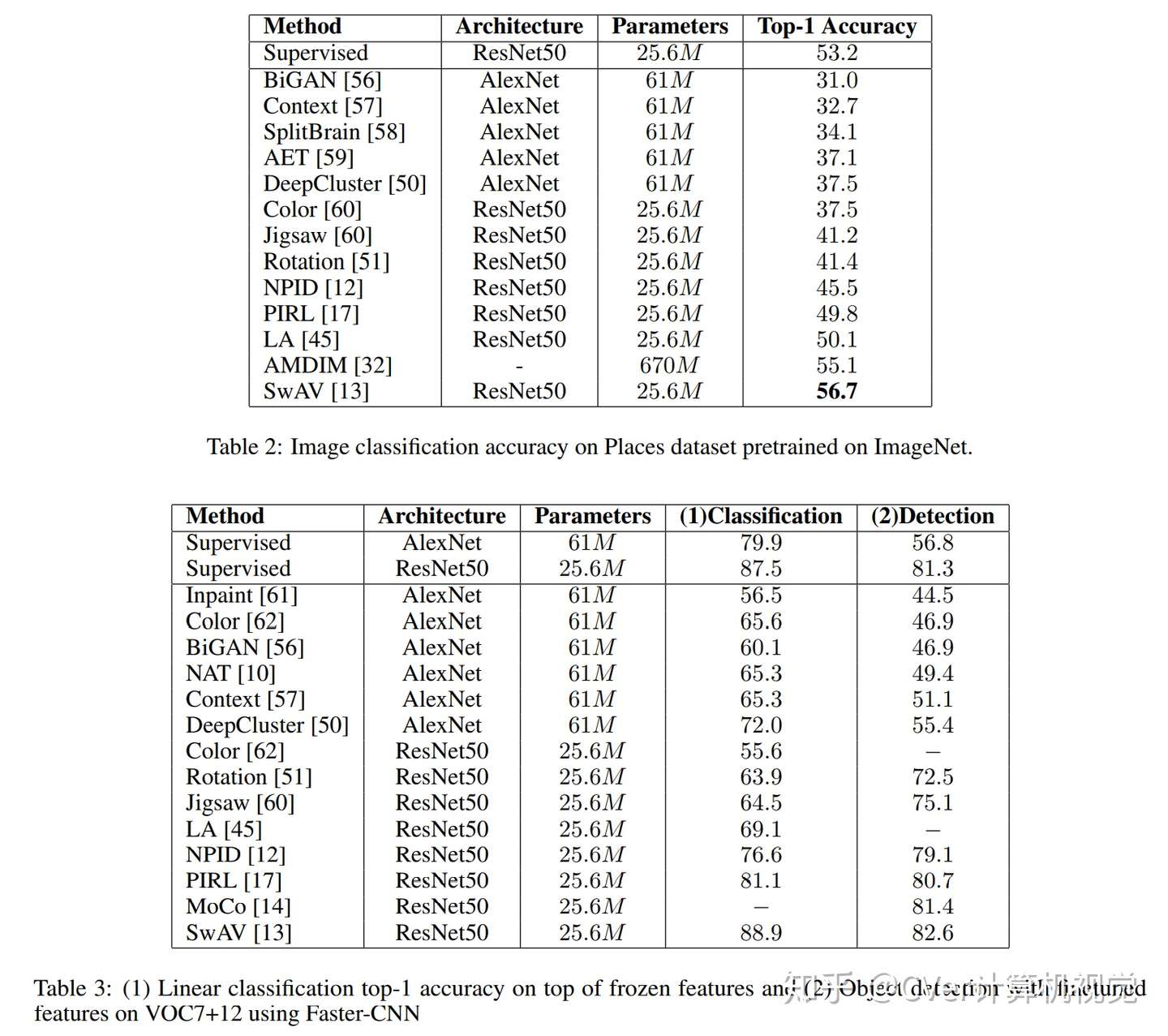

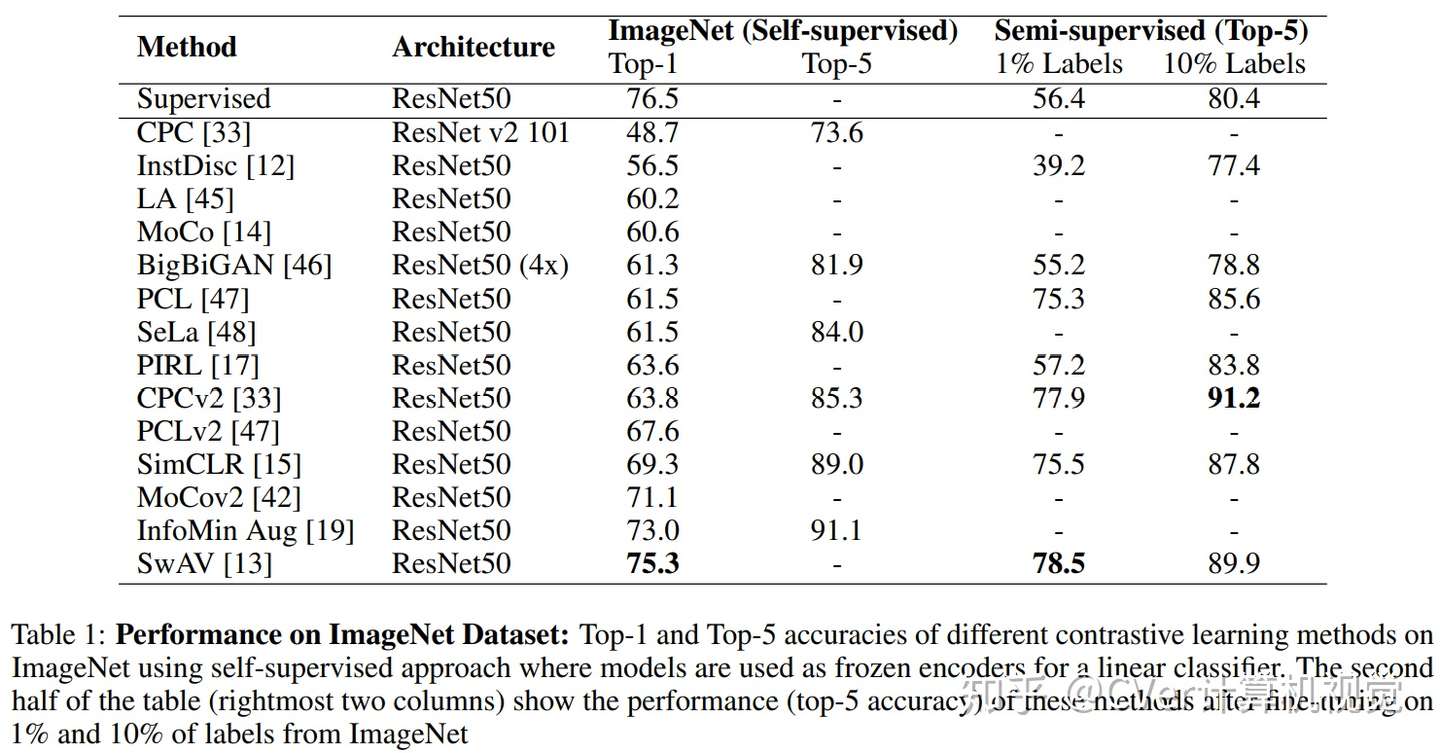

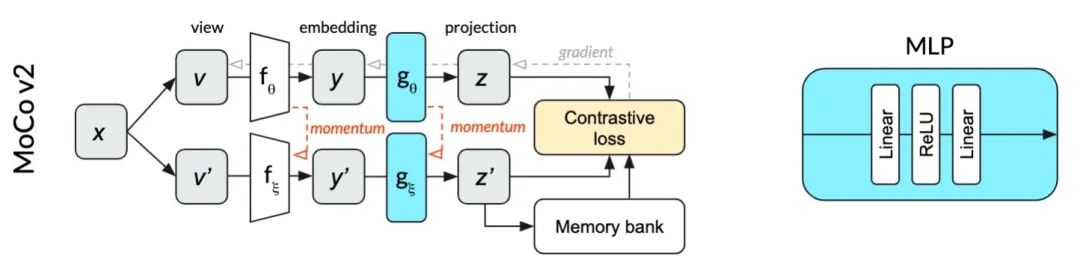

NLP很多任务中为什么需要mask? 1 PAD的问题 通常在训练NLP模型时,batch中的句子长度不相等,这个时候会对没有达到规定长度的句子会进行pad操作(一般用0进行pad),如下图所示(绿色是进行pad的部分):. 欢迎NLP领域的小伙伴们加入rumor建立的「NLP卷王养成群」一起学习,添加微信leerumorrr备注知乎NLP即可,群里的讨论氛围非常好~ 推荐阅读: 4层小模型吊打BERTlarge?亚马逊最新瘦身秘籍 EMNLP|超越MLM,微软打造全新预训练任务 如何优雅地训练大型模型?. 页综述,共计84篇参考文献。本文广泛调研了最近在CV和NLP任务中对比学习表现最佳的自监督方法(如SwAV、MoCo系列、SimCLR系列等)。 A Survey on Contrastive Selfsupervised Learning作者单位:德克萨斯大学阿.

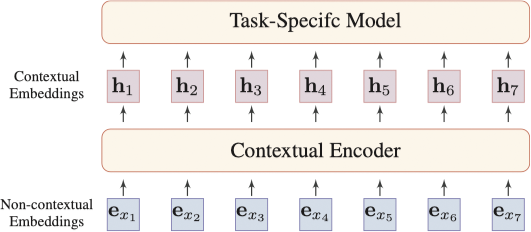

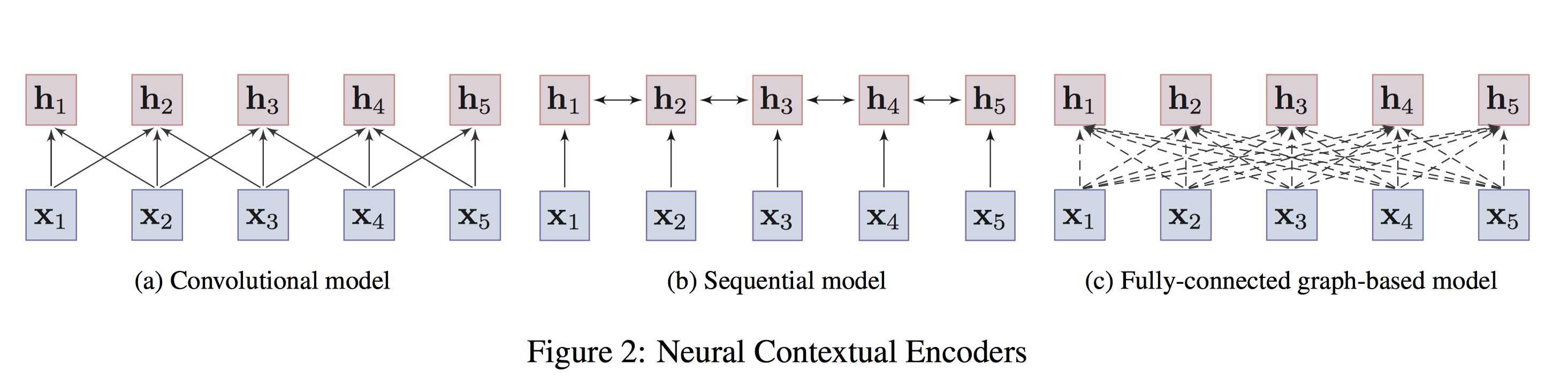

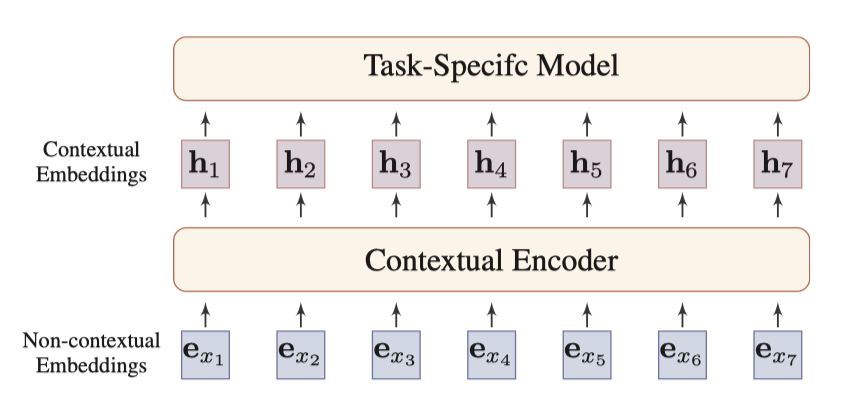

而对比方法通过正面和负面的例子来学习表征。尽管不是全新的思路,但其在计算机视觉任务中取得了较快的发展。通常自监督的对比方法也称为自监督对比学习。 Contrastive Learning 31 Contrastive Loss(InfoNCE) 对比学习的核心思想是最大化相似性和最小化差异性的. Selfsupervised & contrastive learning 第二弹:介绍NLP领域自监督学习和对比学习的最新工作(年)。selfsupervised & contrastive learning. 在 nlp 领域,使用词向量将一个变长文本表示成一个固定向量的常用方法有:1)以词向量为输入,使用一个复杂的神经网络(cnn,rnn 等)来进行文本表示学习;2)在词向量的基础上,直接简单的使用按元素求均值或者相加的简单方法来表示。.

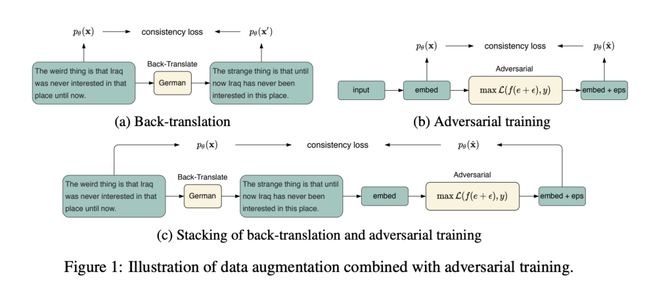

原标题:最新Transformer模型大盘点,NLP学习必备,Google AI研究员出品丨资源 来源:量子位 力机制(Selfattention)的改进,并对这些模型进行对比. Nlp学院4周年:《nlp教练 nlp(中国成都):招聘季,我 彭浩:nlp语言中的财富(第七 连接15第6期《nlp语 萨提亚:心理营养影响我们一生的 彭浩变语言破框架,框架定人生 nlp教练系统:没有困难的事情 nlp语言中的财富(第六期)火. 对比学习的核心在于如何构建正负样本集合,图像领域一般通过旋转、裁剪等图片操作,而文本领域往往通过回译、字符插入删除等方法,这些方法依赖于领域经验,缺乏多样性和灵活性;因此,近期有一些论文(Robust PreTraining by Adversarial Contrastive Learning)通过.

页综述,共计84篇参考文献。本文广泛调研了最近在CV和NLP任务中对比学习表现最佳的自监督方法(如SwAV、MoCo系列、SimCLR系列等)。 A Survey on Contrastive Selfsupervised Learning作者单位:德克萨斯大学阿. Nlp高级执行师:提升你的支持力 对比nlp执行师侧重于提升亲和力,nlp高级执行师更倾向支持力, 销售软件:用心理学完成你的销售指标 升级销售软件,重构销售思维,你才能成为爆单高手! 财富软件:如何让钱爱上你? 深度挖掘你的金钱潜意识,帮你重新了解财富与自我的关系,去除你财富. 作者:李磊( @Tobias Lee ) 单位:西安电子科技大学 研究方向:自然语言处理 最近深度学习两巨头 Bengio 和 LeCun 在 ICLR 上点名 SelfSupervised Learning(SSL,自监督学习) 是 AI 的未来,而其的代表的 Framework 便是 Contrastive Learning(CL,对比学习)。.

8 nlp上的对比学习 提供了一些背景知识,略。 9 讨论和未来方向 尽管实验结果显示对比学习的效果很好,但是它还需要更多的理论论证。 缺少理论支撑 数据增强的选择和前置任务 恰当的负样本采样 数据集偏见 10 结论 这篇论文总结了各种流行的自监督对比. 深度学习用于NLP中的论文及代码集锦。 Characterbased Joint Segmentation and POS ging for Chineseusing Bidirectional RNNCRFYan Shao et alUppsala University, University of HelsinkiIJCNLP 17httpwwwaclweborganthologyI这篇论文提出一种基于字符的模型,用于中文分词和词性标注。该模型框架基于双向RNNCRF,可以用于序列标注. 如何学习NLP和NLP相关资源 如何学习自然语言处理:一本书和一门课 如何学习自然语言处理:NLP领域经典《自然语言处理综论》英文版第三版更新 这门斯坦福大学自然语言处理经典入门课,我放到B站了 数学之美中盛赞的 Michael Collins 教授,他的NLP课程要不要收藏?.

具体研究结果对比 与现有的预训练 nlp 模型相比,electra 的学习效率要高得多。但值得注意的是,目前 glue 上的最佳模型(例如 t5(11b))不适合. 对比学习是一种可选择的补充范式,可以帮助缓解其中的一些问题。 对比学习与 masked 语言建模相结合能够让我们学习更丰富、更鲁棒的表征。它可以帮助解决模型异常值以及罕见的句法和语义现象带来的问题,这对当前的 NLP 模型是一个挑战。. NLP大赛冠军总结:300万知乎多标签文本分类任务(附深度学习源码) 刚开始训练的时候Embedding层的学习率为0 ,其它层的学习率为1e3,采用Adam优化器(一开始的时候卷积层都是随机初始化的,反向传播得到的Embedding 第一列的对比模型采用的是RNN(不采用数据.

综述 对比自监督学习技术 全面调研 知乎

Iclr Nlp预训练模型的全新范式 对比学习 码农家园

自然语言处理理论与实战 唐聃 Pdf源代码 大数据智能互联网时代的机器学习和自然语言处理技术 刘知远 Pdf 对比学习 热备资讯

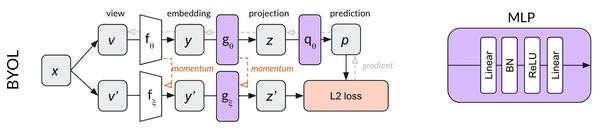

一文梳理无监督对比学习 Moco Simclr Swav Byol Simsiam 极市高质量视觉算法开发者社区

对比学习 Contrastive Learning 相关进展梳理 知乎

基于深度迁移学习的多语种nlp技术原理和实践 Infoq

今晚直播 清华大学 高天宇 对比学习及其在nlp中的应用 Paper Weekly Csdn博客

6大最流行 最有用的自然语言处理库对比 电子创新网赛灵思社区

对比自监督学习浪潮迅猛来袭 你准备好了吗 向量 编码器 算法 聚类 样本 网易订阅

从零开始学习自然语言处理 Nlp Deeppavlov框架解析 4 作业部落cmd Markdown 编辑阅读器

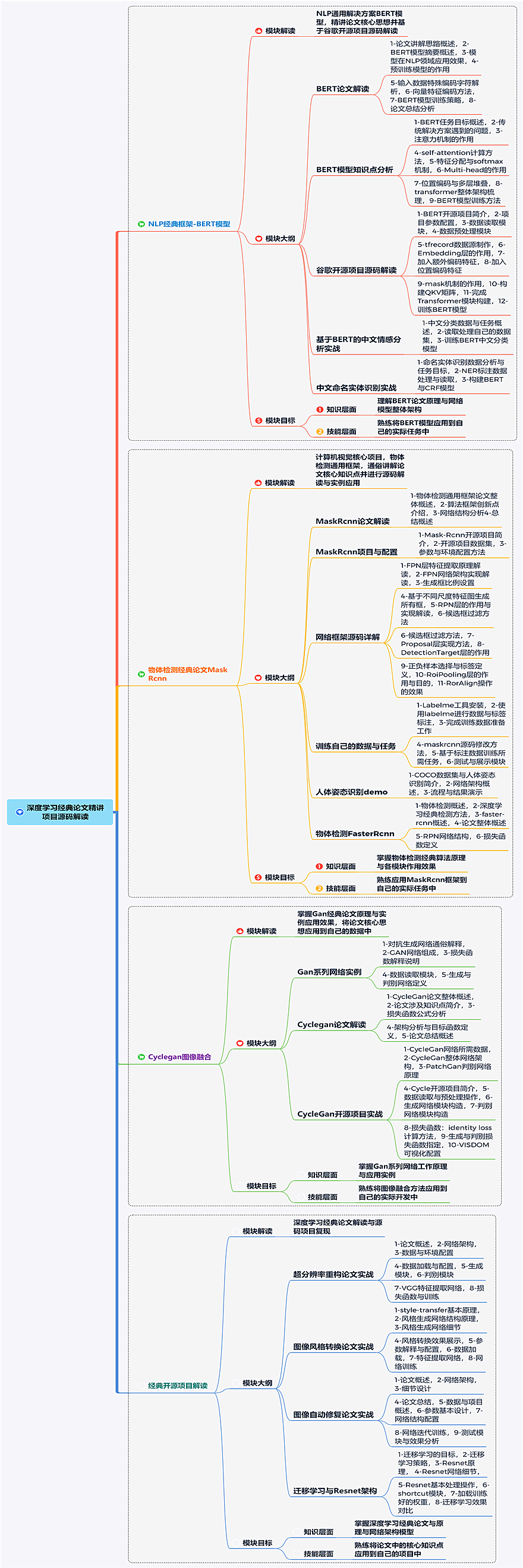

模型在nlp领域应用效果 深度学习经典论文与开源项目实战 深度学习视频 51cto学院

谷歌最强nlp模型 Bert 大大大大碗面

人工智能与自然语言处理概述 Ai三大阶段 Nlp关键应用领域 It青年舍

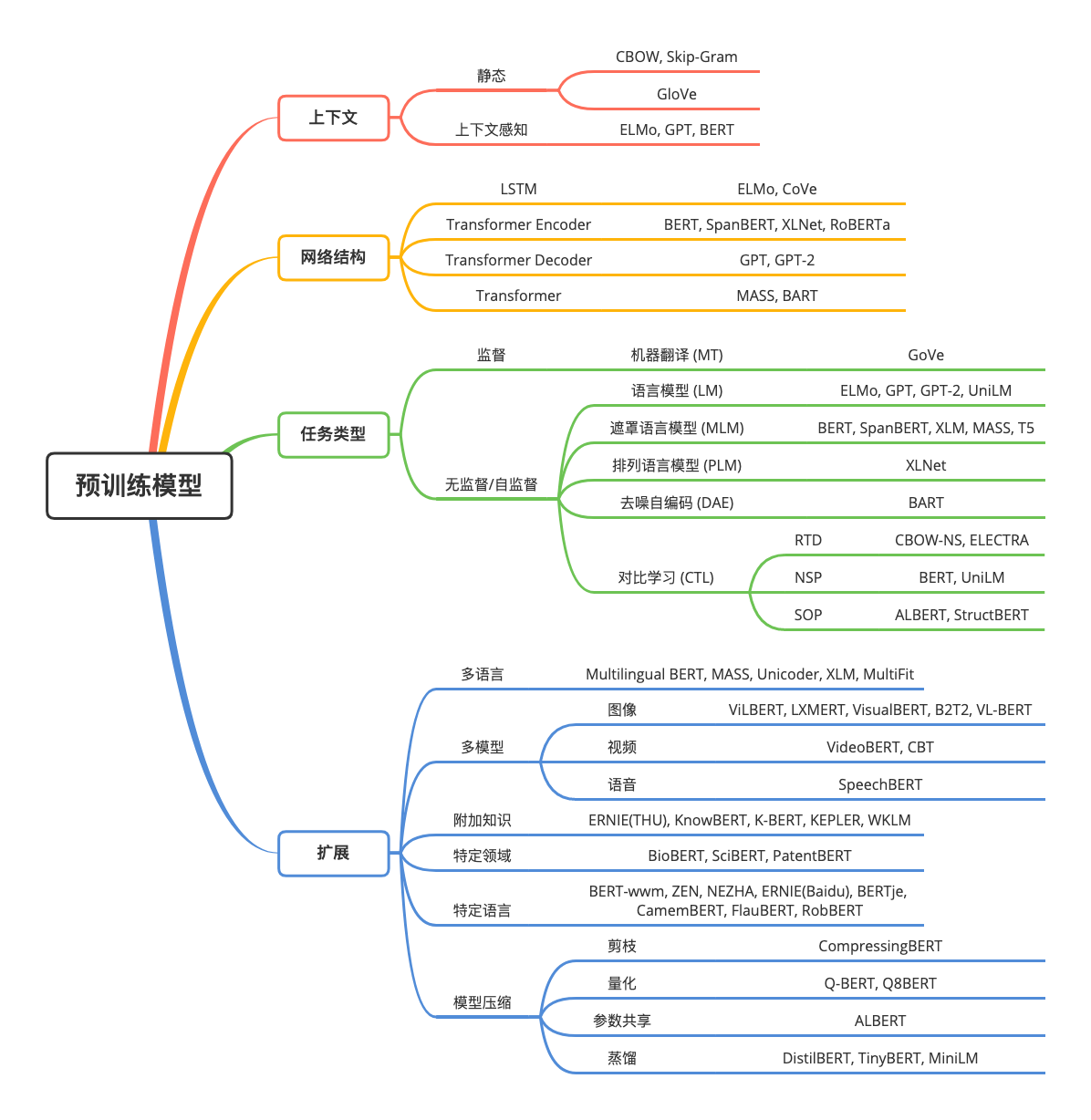

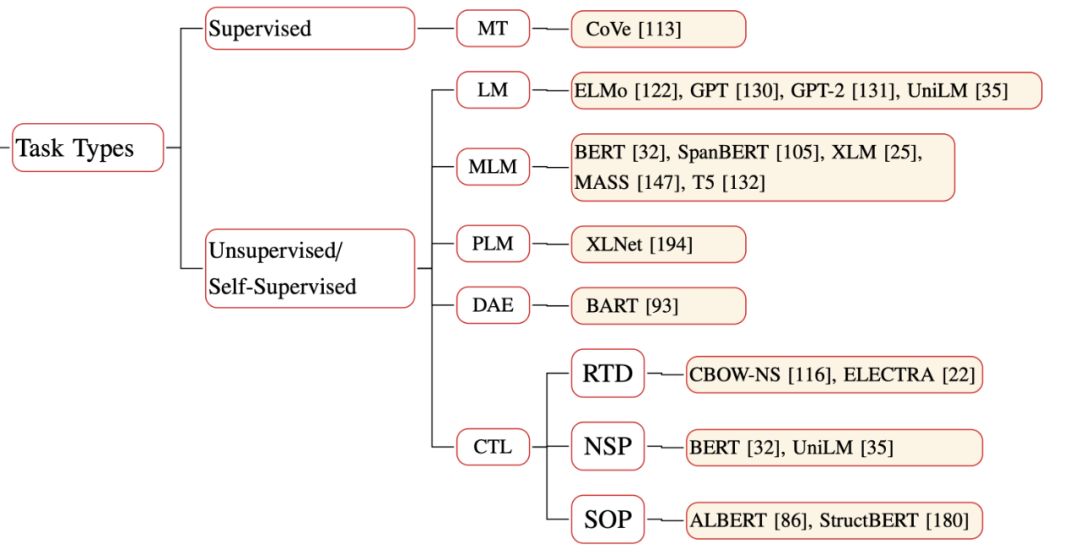

转自知乎 Nlp算法面试必备 史上最全 Ptms Nlp预训练模型的全面总结

图解simclr框架 用对比学习得到一个好的视觉预训练模型 极术社区 连接aiot 开发者与生态服务

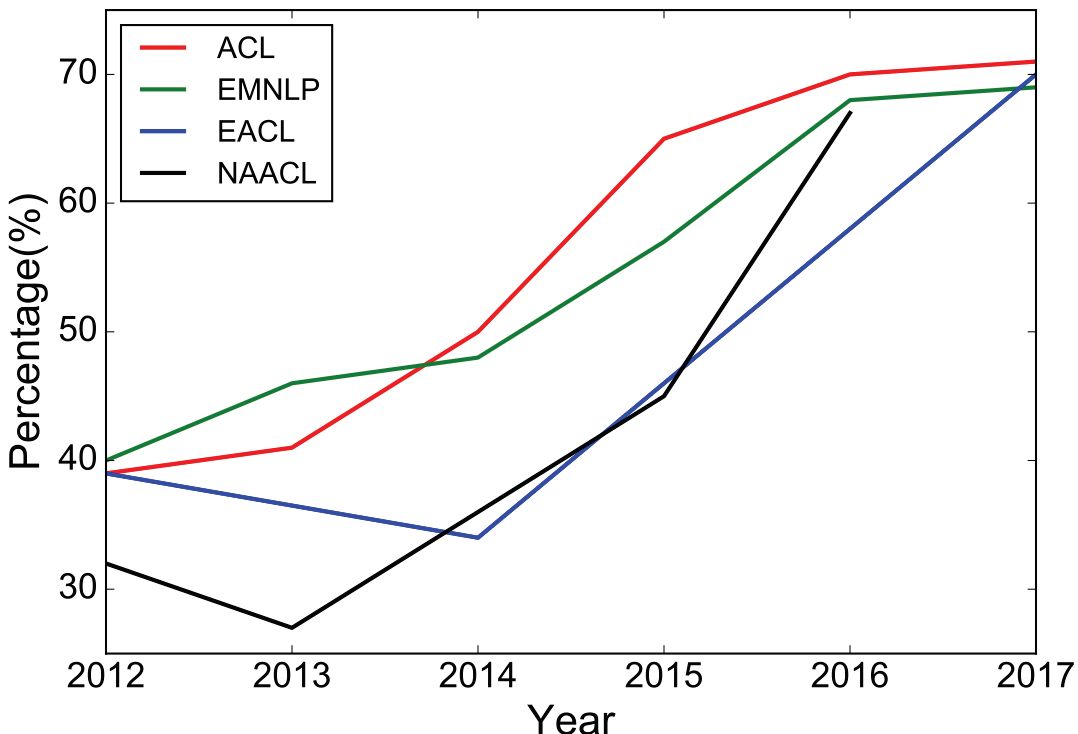

Nlp领域 学霸 太多 一年前标准已过时 新跑分标准superglue出炉 量子位

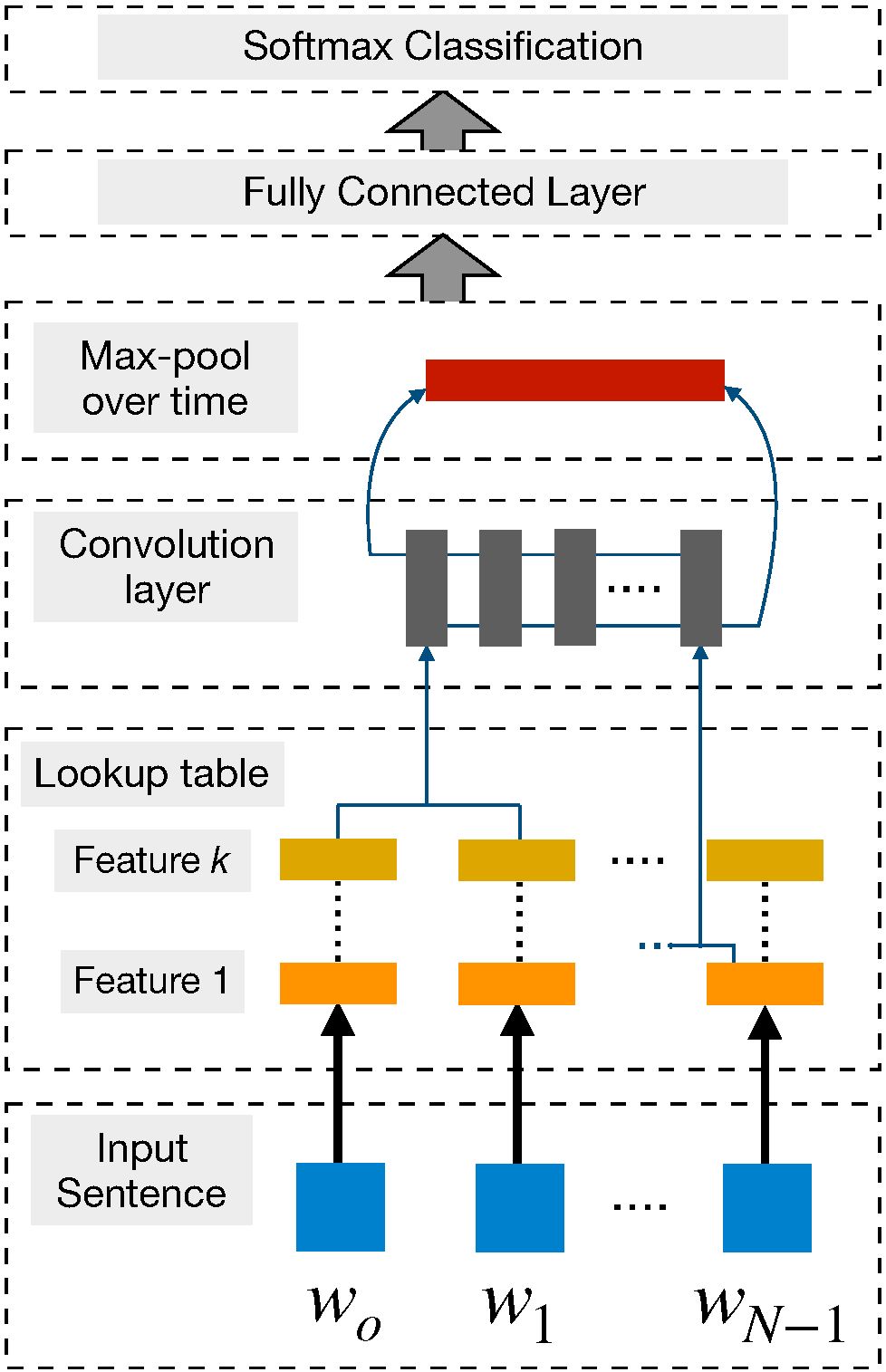

Cnn和rnn在nlp任务中的对比实验 程序员大本营

Nlp中的自监督学习和对比学习 哔哩哔哩 つロ干杯 Bilibili

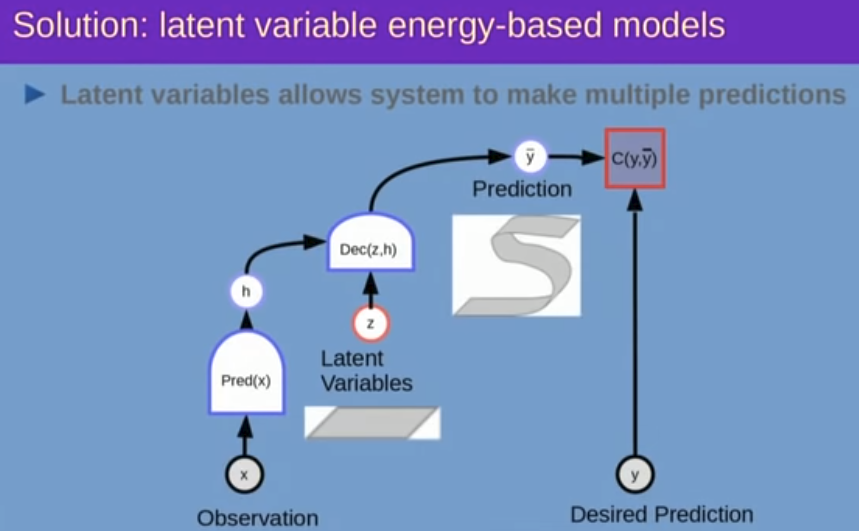

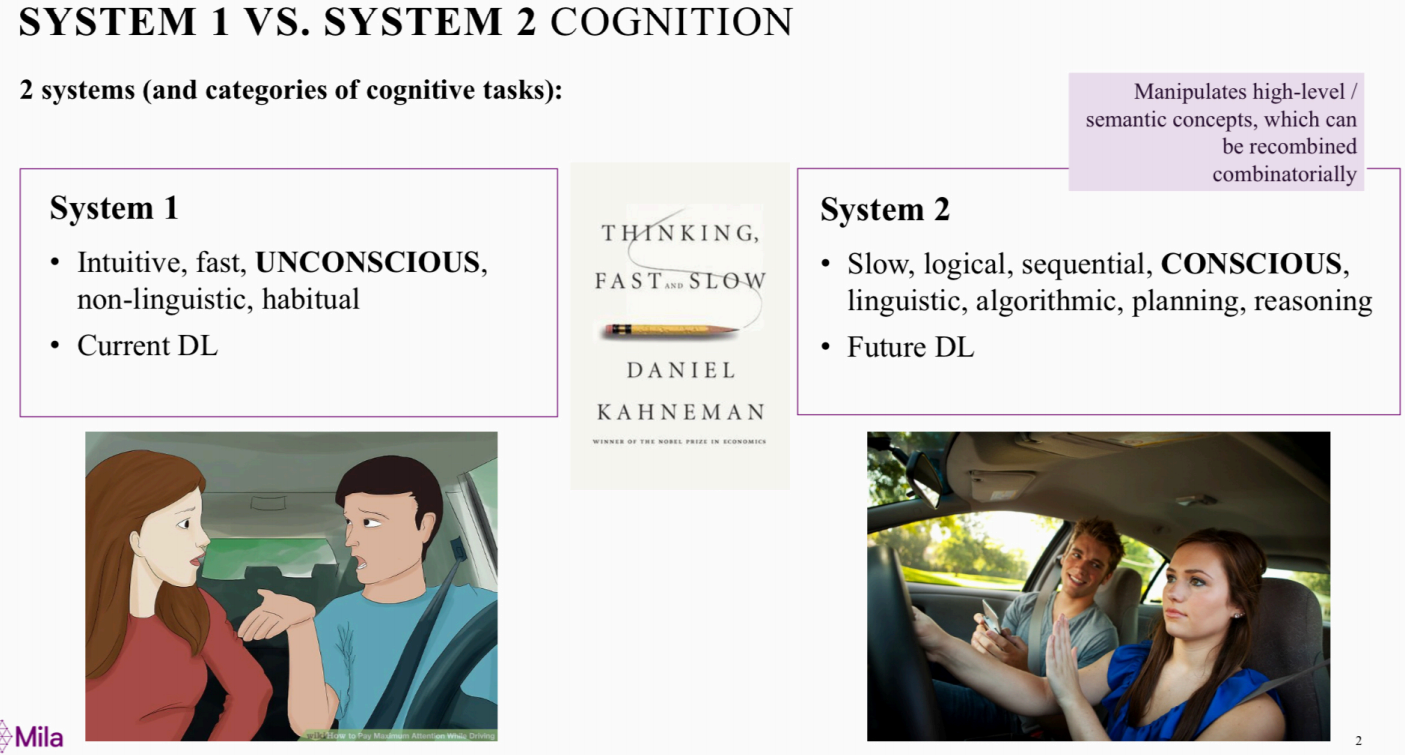

更高级的认知是 感知 问题吗 意识先验 Consciousness Prior 正演模型 Forward Model 对比学习 Contrastive Learning 系统2 的认知问题 ai主题演讲精要 二 David 9的博客

Nlp 近期必读iclr 21相关论文 深度学习自然语言处理 商业新知

深度学习在nlp中的应用 递归自编码 情感分析 华为云

预训练自然语言模型 Pre Trained Models For Nlp Leo Van 范叶亮

Cnn和rnn在nlp任务中的对比实验 Jeepxie Net

Nlp文本情感分析实战训练营

Ptms Nlp预训练模型综述 蘑菇先生学习记

对比学习 Contrastive Learning 相关进展梳理 闪念基因 个人技术分享

对比学习 Contrastive Learning 相关进展梳理 Paperweekly 二十次幂

用对比学习训练说话人初步验证模型 人工智能遇见磐创 博客园

对nlp 迁移学习了解得有多深 回答完这21 个问题就知道了 雷锋网

综述 对比自监督学习技术 全面调研 知乎

自监督文献综述 乱七八糟的自然语言处理版 码农家园

Transformers Nlp界的 大哥 丨emnlp 最佳demo论文 Aminer

自然语言处理中的预训练模型 Xxwywzy S Blog

Python自然语言处理实战核心技术与算法 Python自然语言处理 Pytorch深度学习实战 下载

对nlp 迁移学习了解得有多深 回答完这21 个问题就知道了 雷锋网

我爱自然语言处理 I Love Natural Language Processing

从基于规则到深度学习 Nlp 技术进阶三部曲 产品经理的人工智能学习库

不妨试试moco 来替换imagenet上pretrain模型 技术圈

对nlp 迁移学习了解得有多深 回答完这21 个问题就知道了 雷锋网

详解下一代神经网络 无监督对比学习框架simclr Osc 19sil6fy的个人空间 Oschina

Iclr Nlp 預訓練模型的全新範式 對比學習 每日頭條

Ptms Nlp预训练模型综述 蘑菇先生学习记

对比学习 Contrastive Learning 相关进展梳理 Paperweekly Mdeditor

Contrastive Learning 学习笔记 Stay Hungry Stay Foolish

入门 6大最流行 最有用的自然语言处理库对比

自然语言处理 语雀

Python自然语言处理 智能系统与技术丛书 3 1 3 Nlu和nlg的区别

美团bert的探索和实践 美团技术团队

Acl 微软亚洲研究院精选论文带你一览nlp前沿

开源nlp 自然语言处理 库的功能对比

用对比学习训练说话人初步验证模型 磐创ai

转自知乎 Nlp算法面试必备 史上最全 Ptms Nlp预训练模型的全面总结 苏轶然 博客园

最新 对比监督学习 综述论文 页pdf 专知 微信公众号文章阅读 Wemp

Neurips 自步对比学习 充分挖掘无监督学习样本 夕小瑶的卖萌屋 Csdn博客

Pre Training In Nlp Ripshun Blog

无监督表示学习 一 18 Contrastive Predictive Coding Cpc 简书

论文浅尝 Emnlp 基于分组式对比学习的神经对话生成 开放知识图谱 Csdn博客

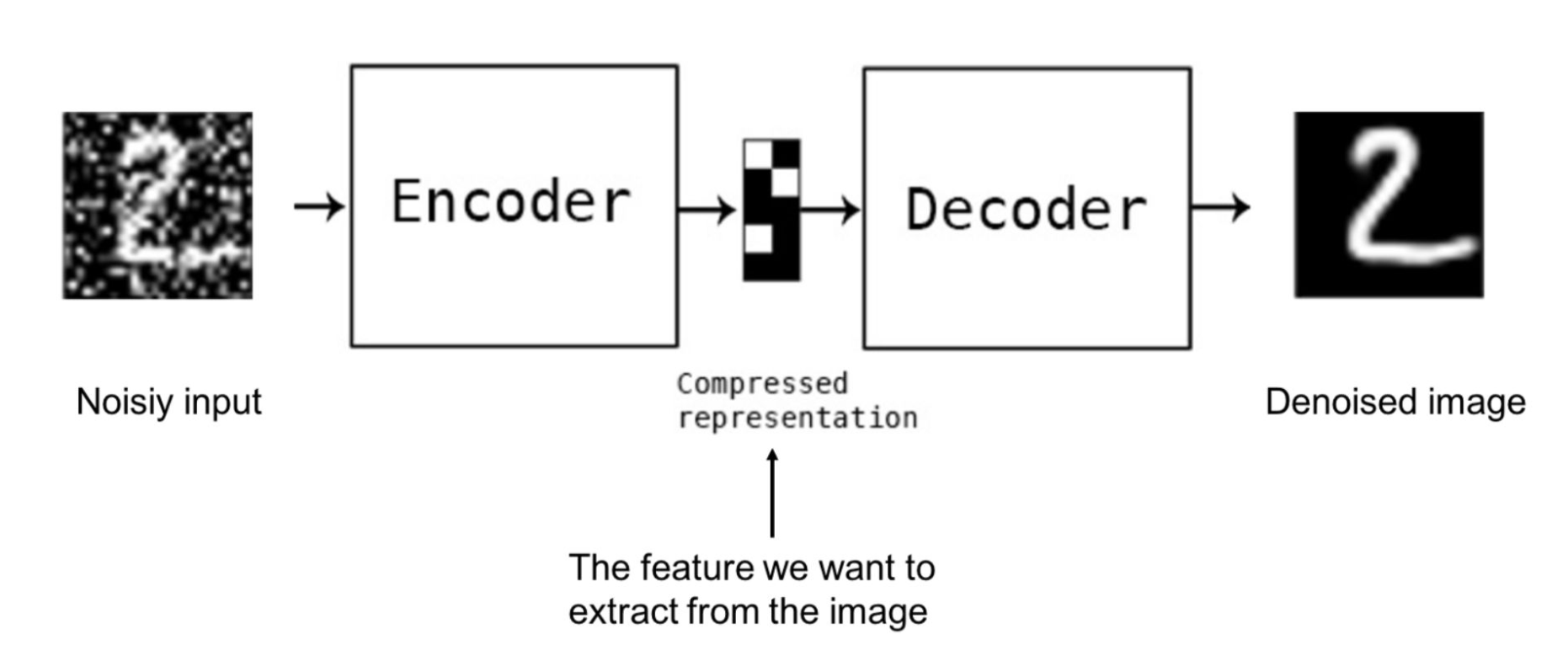

自然语言处理 Nlp 一文带你了解自编码器 Autoencoder 简书

Pw Live直播 清华大学 高天宇 对比学习及其在nlp中的应用 Paperweekly Mdeditor

Contrastive Learning 学习笔记 Stay Hungry Stay Foolish

学习nlp 自然语言处理综论第2版 中文pdf 英文pdf 对比分析 代码天地

一文看懂nlp里的分词 Tokenization 中英文区别 3大难点 3种典型方法 By Easyai 人工智能知识库 Medium

人工智能机器学习自然语言处理学习资料 语雀

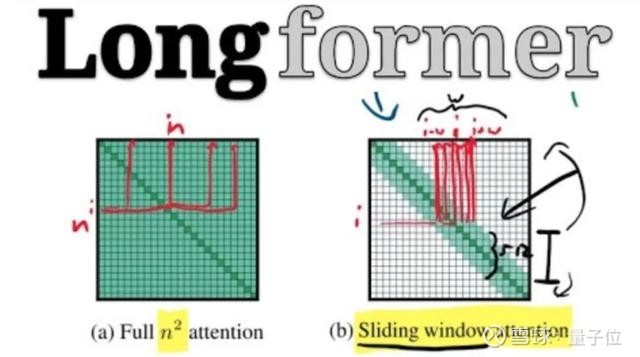

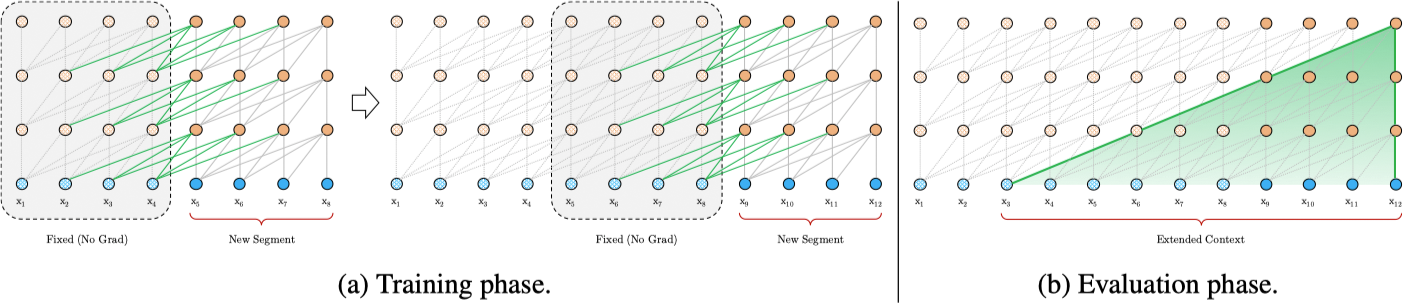

最新transformer模型大盘点 Nlp学习必备 Google Ai研究员出品丨资源萧箫发自凹非寺量子位报道 公众号qbitai 可高效处理长文本的模型longformer 和堪称 升级版

Nlp 机器学习 学习视频教程 腾讯课堂

Nlp这两年 15个预训练模型对比分析与剖析 机制

Nlp中的自监督学习和对比学习 哔哩哔哩 つロ干杯 Bilibili

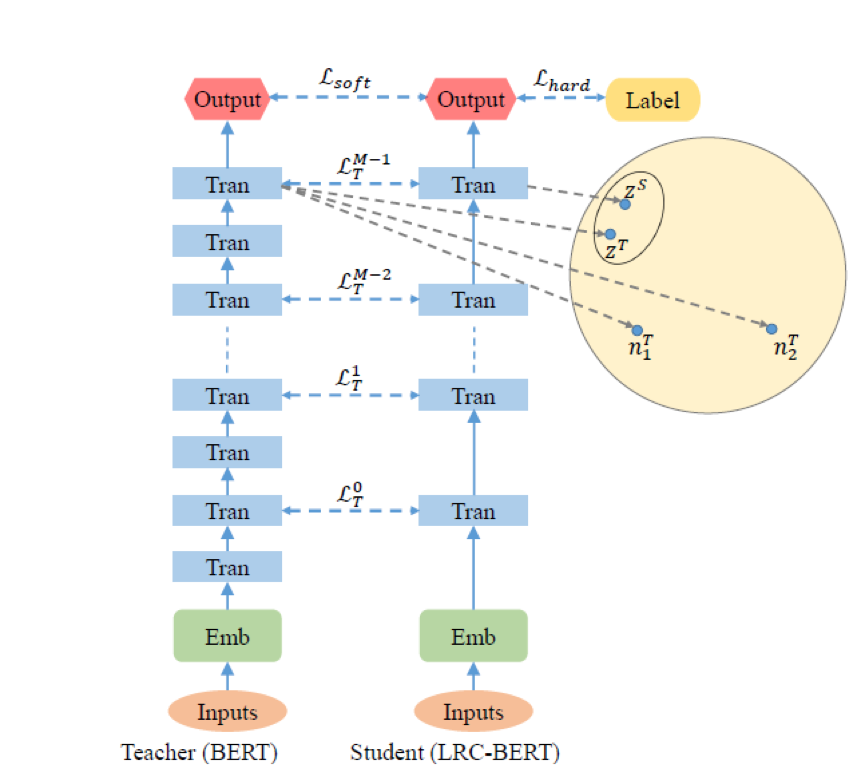

Lrc Bert 对比学习潜在语义知识蒸馏 ai 21 技术圈

百度 阿里 腾讯 Bat 三家公司自然语言处理api对比与使用 价格分析以及选取 Pytorch中文网

近期必读的七篇neurips 对比学习 相关论文和代码 专知 二十次幂

今晚直播 清华大学高天宇 对比学习及其在nlp中的应用 专知

预训练自然语言模型 Pre Trained Models For Nlp Leo Van 范叶亮

万字长文概述nlp中的深度学习技术 生涯频道 领研网

复旦邱锡鹏超全nlp预训练模型综述论文 两张图带你梳理完整脉络 湃客 澎湃新闻 The Paper

综述 对比自监督学习技术 全面调研 知乎

ai21 Lrc Bert 对比学习潜在语义知识蒸馏 专知 微信公众号文章阅读 Wemp

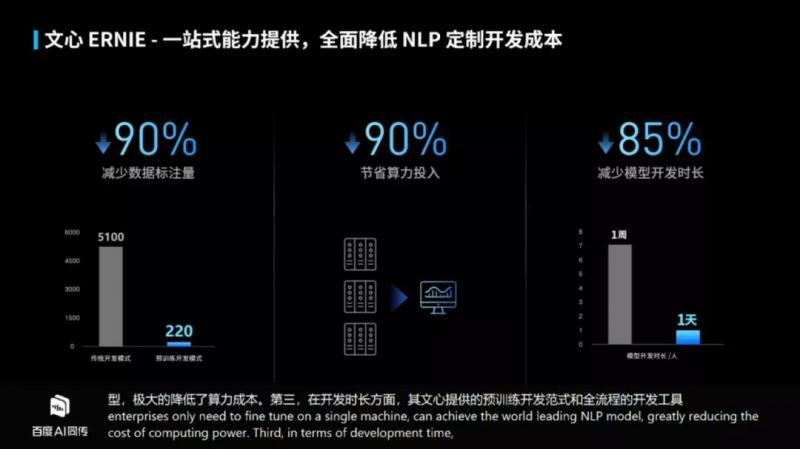

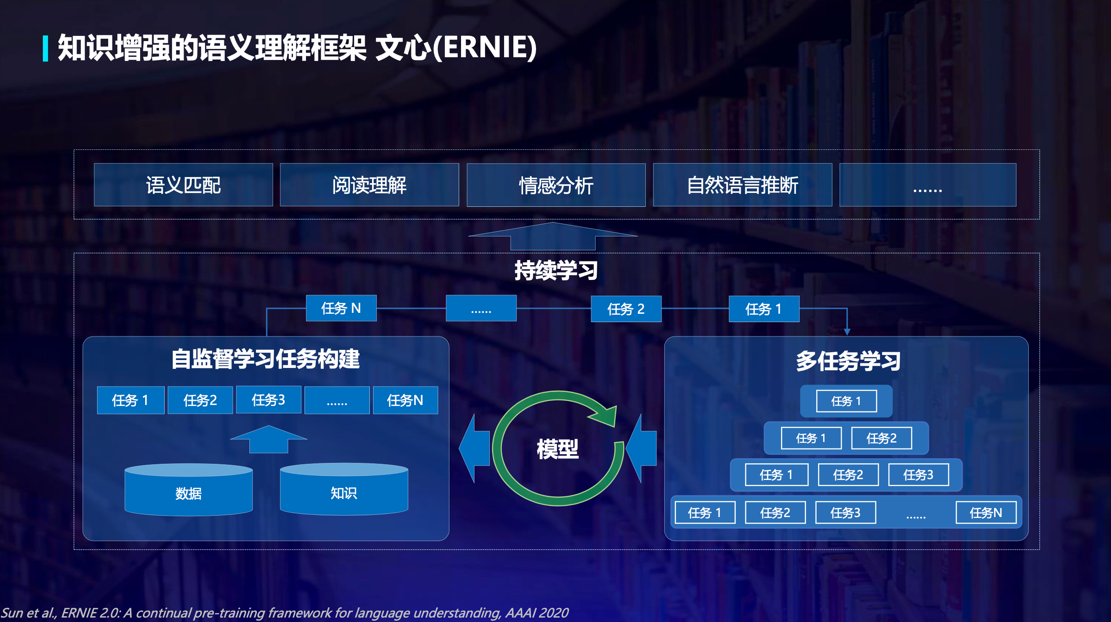

百度nlp的十年 今夕与未来 工业电子 与非网

对比学习 Contrastive Learning 相关进展梳理 Hold The Torch

Ai 人工智能新闻资讯 对比自监督学习浪潮迅猛来袭 你准备好了吗

收录160 篇文章 清华唐杰团队详解自监督学习 Aminer

Iaanlp心理学课程与传统心理学课程对比 Iaa Nlp培训移动站

复旦邱锡鹏超全nlp预训练模型综述论文 两张图带你梳理完整脉络 手机新浪网

今晚直播 清华大学 高天宇 对比学习及其在nlp中的应用 交流

自监督 半监督和有监督全涵盖 四篇论文遍历对比学习的研究进展 新浪科技 新浪网

王海峰详解百度nlp十年技术完整布局 Infoq

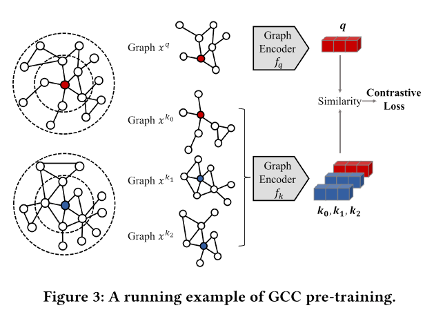

论文阅读 图上的自监督学习 对比学习论文解读 Hades Jun

预训练自然语言模型 Pre Trained Models For Nlp Leo Van 范叶亮

我爱自然语言处理 I Love Natural Language Processing

更高级的认知是 感知 问题吗 意识先验 Consciousness Prior 正演模型 Forward Model 对比学习 Contrastive Learning 系统2 的认知问题 ai主题演讲精要 二 David 9的博客

人工智能cvbinlp 三大方向优劣对比 程序猿

无监督学习之对比学习 安全客 安全资讯平台

一文梳理年大热的对比学习模型 我爱计算机视觉的个人空间 Oschina

万字长文概述nlp中的深度学习技术 生涯频道 领研网

学习nlp前后对比 中国nlp汽车学院